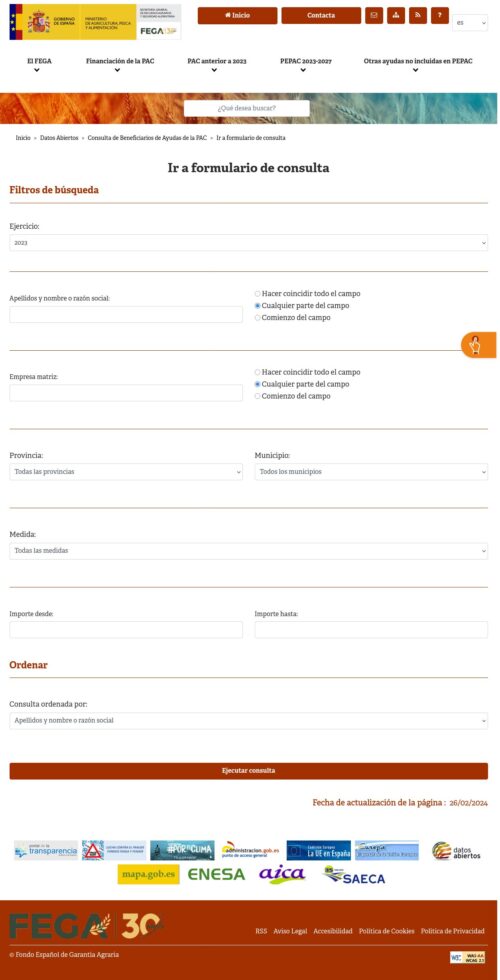

Consulta de Beneficiarios de Ayudas de la PAC

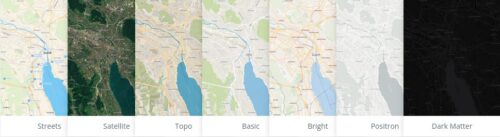

The vector tile schema describes how the vector data is organized into different thematic layers and which attribute and values each layer contains. This is useful for writing a map style and allows for alternative implementations of a schema.

The OpenMapTiles schema is open (CC-BY) and you are free to use, extend or build upon the existing implementation (BSD license). Attribution is required. Please properly reference OpenMapTiles if you build upon the schema.

The vector tile schema has been developed by Klokan Technologies GmbH and was initially modelled after the cartography of the Carto Basemap Positron. The vector tile schema has been refined and improved in cooperation with the Wikimedia Foundation and is heavily influenced by the many years Paul Norman’s experience of creating maps from OpenStreetMap.

Frictionless is an open-source toolkit that brings simplicity to the data experience – whether you’re wrangling a CSV or engineering complex pipelines.

CKAN is an open-source DMS (data management system) for powering data hubs and data portals. CKAN makes it easy to publish, share and use data. It powers hundreds of data portals worldwide.

La plataforma social «València per l’aire» som una iniciativa organitzada de ciutadania col·lectiva, autònoma i plural. Els motius i finalitats generals que ens mouen cerquen solucions eficaces que milloren la qualitat de l’aire urbà de la ciutat de València i de l’entorn metropolità. Ens hem dotat de mitjans tècnics propis que són necessaris per a realitzar mesuraments i vigilància sobre la qualitat de l’aire. Produïm i difonem informació objectiva i socialment accessible sobre la contaminació de l’aire de València i la seua àrea metropolitana. També realitzem un seguiment continuat i unes valoracions especifiques per zones sobre la composició de l’aire i la presència de components tòxics.

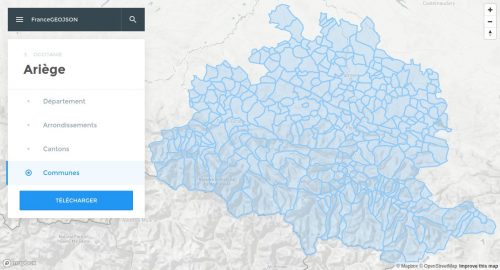

Le projet Github france-geojson propose au format GeoJSON les cartes des régions, départements, arrondissements, cantons et communes de France (métropole et départements d’outre-mer) à partir des données publiées par l’IGN et l’INSEE.

Ce site permet de rechercher, visualiser et télécharger individuellement chacun de ces fichiers dans un format optimisé. Pour plus de détails ou pour accèder à la version non optimisée des tracés, cliquez sur le bouton ci-dessous.

The public deserves the most complete data available about COVID-19 in the US. No official source is providing it, so we are.

The COVID Tracking Project

Every day, our volunteers compile the latest numbers on tests, cases, hospitalizations, and patient outcomes from every US state and territory.

Explora 20.971 contratos del Gobierno de Cantabria y más de 4.000 licitadores. Una herramienta digital interactiva para la transparencia y el análisis desarrollada por Jaime Gómez-Obregón.

We are facing an unprecedented public health crisis with the Coronavirus (Covid-19) outbreak. We believe that data-driven decisions, and people working together for the greater good, are the best way through this difficult time. Right now, it’s more important than ever to have the resources to answer critical questions that matter to your organization and people. This includes having access to timely, detailed, and trustworthy data to think quickly and move fast. We have gathered the power of our Tableau Community and our technology to create a free Covid19 Data Resource Hub to help you make confident decisions with data.

L’information officielle sur la progression de l’épidémie en France est assez fragmentée, et n’est presque jamais structurée sous forme de données.

L’objectif de ce jeu de données est de consolider l’information officielle, et de la rendre disponible dans des formats ouverts et aisément réutilisables (JSON, CSV…).

Granularité

Les données sont proposées selon plusieurs granularités : monde, pays (France), région et département.

Les données à la maille du département sont actuellement très fragmentaires.

Sources utilisées

Santé publique France

Préfectures

Agences Régionales de Santé

Ministère des Solidarités et de la Santé

Code source et issues

Lien vers le projet de collecte de données. Signalez les problèmes et erreurs de données en créant des issues à l’adresse suivante :

https://github.com/opencovid19-fr/data

Pese a tanta recomendación y que sea software libre, cuando pides el código fuente de esta plataforma, la respuesta de red.es argumenta que su liberación podría ocasionar un perjuicio para su poseedores (red.es como reconocen en la resolución) y se acogen a esta cláusula de la ley de transparencia acceso a la información y buen gobierno para denegarlo. (Pese a que dicen que conceden parcialmente, la realidad es que no conceden nada)

Ces fichiers contiennent l’ensemble des communes françaises, y compris les DOM, Mayotte et Saint-Pierre-et-Miquelon. Pour Paris, Lyon, Marseille, ce sont les limites d’arrondissements qui sont fournies à la place des limites de communes.

Pour chaque commune ou arrondissement, les attributs suivants sont ajoutés:

insee: code INSEE à 5 caractères de la commune

nom: nom de la commune (tel que figurant dans OpenStreetMap, si possible conforme aux règles de toponymie)

wikipedia: entrée wikipédia (code langue suivi du nom de l’article)

surf_ha : surface en hectares de la commune

The service, called Dataset Search, launches today, and will be a companion of sorts to Google Scholar, the company’s popular search engine for academic studies and reports. Institutions that publish their data online, like universities and governments, will need to include metadata tags in their webpages that describe their data, including who created it, when it was published, how it was collected, and so on. This information will then be indexed by Dataset Search and combined with input from Google’s Knowledge Graph. (That’s the name for those boxes that pop up for common searches. So if dataset X was published by CERN, some info about the institute will also be included in the results.)