Cathy O’Neil : pour une éthique des algorithmes

Quel est son parcours et d’où lui est venue sa passion pour les mathématiques ? Pourquoi appelle-t-elle les algorithmes des “armes de destruction mathématiques” ? Comment ces nouveaux pouvoirs algorithmiques transforment-ils les pratiques professionnelles de la société ?

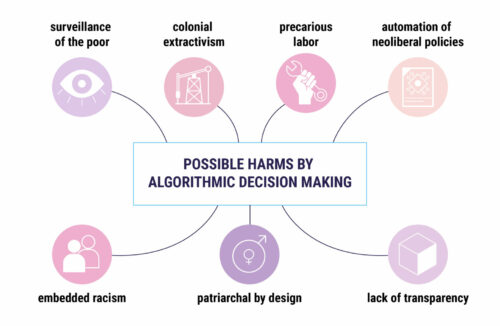

Quoi de plus neutre qu’un ordinateur ? Quoi de plus a priori objectif qu’une suite de calculs, qu’une série d’opérations mathématiques ? Quoi de plus éloigné d’une opinion finalement qu’un algorithme ? Et bien tout justement. Parce qu’ils sont programmés par des humains qui sont eux perclus de biais, parce qu’ils tentent d’objectiver des réalités qui sont plus complexes que ce que peut décrire une seule suite mathématique, parce qu’enfin derrière chaque algorithme il y a une intention et qu’une intention n’est pas neutre. Pour notre invitée du jour, les algorithmes sont devenus des weapons of math destruction, des armes de destruction mathématique.

La mathématicienne, informaticienne et activiste Cathy O’Neil est notre toute dernière invitée de l’année. Bienvenue dans la Méthode scientifique.